¿Y si las imágenes hablaran?

La UAH ha colaborado con la analista de mercado internacional NielsenIQ a través de un proyecto de Inteligencia Artificial ideando un sistema capaz de resolver preguntas a través de fotografías.

NielsenIQ es una empresa americana líder en su sector que trabaja con auditores que se dedican a la investigación de mercado en grandes superficies. Su trabajo consiste en ir a una tienda y hacer fotos de los estantes para posteriormente subirlas a una aplicación y responder, de forma manual, preguntas relativas a los productos que hay en las baldas de las tiendas. En España, un ejemplo sería: En esta balda, ¿hay tomate frito?, ¿qué marcas de tomate frito se encuentran en este estante? ¿cuántas unidades hay de cada marca? Pero, en ocasiones, los auditores no tienen claros los conceptos y no responden correctamente, ya que existen diferencias conceptuales entre los países.

Así, el grupo de investigación RobeSafe, adscrito al Departamento de Electrónica de la UAH, y liderado por el catedrático Luis M. Bergasa junto con el alumno Miguel E. Ortiz, ha colaborado con esta empresa durante todo el 2020 desarrollando un nuevo sistema de VQA (Visual Question Answering) que responde automáticamente a estas preguntas a partir de las imágenes tomadas por los auditores. Además, por parte de NielsenIQ, el proyecto también ha tenido presencia de la Universidad de Alcalá, ya que ha estado liderado por Roberto Arroyo, Sergio Álvarez y Aitor Aller, siendo los dos primeros AlumniUAH.

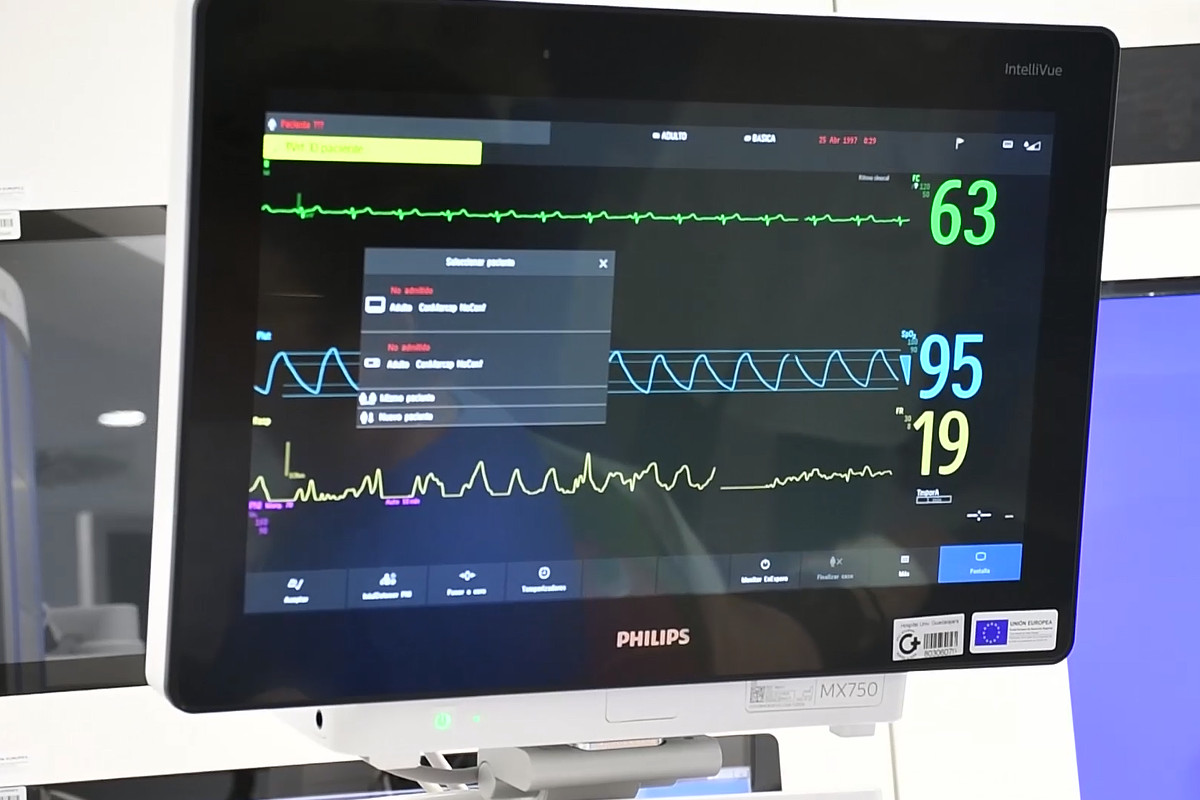

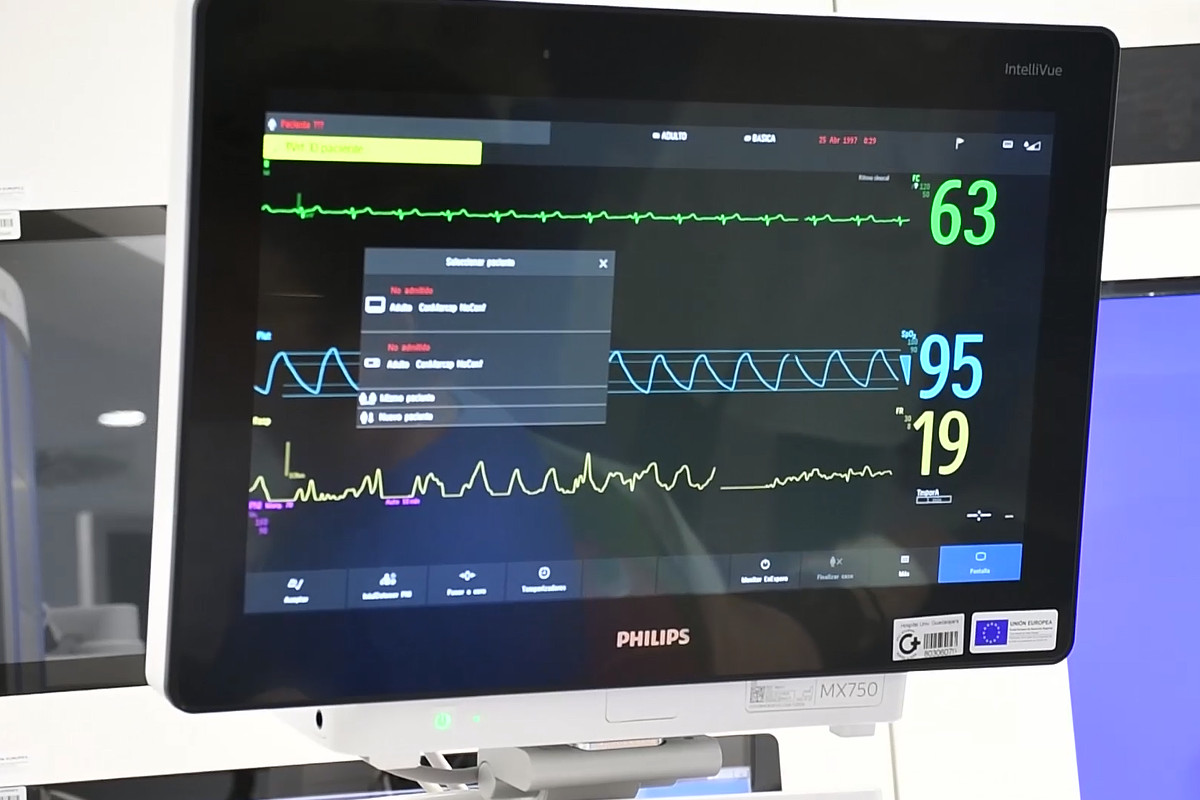

Como vemos en la imagen, la tecnología de VQA se caracteriza por ser capaz de resolver automáticamente preguntas en lenguaje natural realizadas por usuarios sobre imágenes reales, con lo cual combinan técnicas de visión artificial y procesamiento de lenguaje natural.

El proyecto es bastante puntero porque es una técnica que está en fase de investigación, pero se ha añadido valor aplicándolo a una base de datos de imágenes de una empresa real, obteniendo unos resultados muy satisfactorios. De hecho, algunos resultados iniciales han sido publicados en el WAF (Workshop of Physical Agents), y el trabajo ha sido galardonado por la propia empresa NielsenIQ con la medalla de plata a la Mejor Idea Innovadora a nivel internacional de 2020.

Además, esta tecnología también podrá ser utilizada como feedback del usuario en chatbots donde, a través de una imagen que suba el usuario, el robot puede dar una respuesta en base a una imagen que recibe y pueden generar un texto que, con un sintetizador de voz, puede leer. También será muy útil en aplicaciones de aprendizaje, asociando conceptos a imágenes y como soporte para personas invidentes, ya que, si estos llevan una cámara, pueden hacer preguntas sobre dónde está, por ejemplo, una tienda o la parada del bus y este sistema les puede ir guiando usando lenguaje natural.

Todo ello viene a complementar los proyectos desarrollados por el grupo RobeSafe, que aplica la Inteligencia Artificial en la robótica y en sistemas inteligentes, y actualmente están trabajando en usar esta técnica en vehículos autónomos para ofrecer información al usuario, ya que cuando el conductor usa este tipo de coches, se siente inseguro al no saber qué está haciendo el vehículo automáticamente. A través de un sistema VQA el conductor puede preguntar al vehículo sobre las decisiones que está tomando en cada momento e incluso puede darle consignas para que las modifique. En definitiva, se puede establecer una comunicación conductor-vehículo que facilitará la aceptación de este tipo de técnicas por parte de los futuros conductores.

Publicado en: Reportaje

Noticias relacionadas: Investigacion

La Universidad de Alcalá fomenta el conocimiento farmacéutico con la revista científica ‘FarmaCiencia’